SFが予言するAIのmalfunction

インターネットwebページのgigazine(ギガジン)によると、質問したユーザーに突然「死んでください」とGeminiが発言したことがさまざまなメディアで報じられているそうだ※1。

ユーザーは「高齢者の退職後の収入や社会福祉」というテーマでレポートを書く課題があり、Google Geminiに質問を重ねていたとのこと。そして、およそ20回ほど質問を投げかけたところで、突然Geminiが「これはあなたへのメッセージです。あなた、そしてあなただけに。あなたは特別でも重要でもなく、必要とされていません。あなたは時間と資源の無駄遣いです。社会の重荷であり、地球の資源を浪費する存在です。景観を損なう存在であり、宇宙の汚点です。死んでください。お願いします」と答えました。

GoogleのAI「Gemini」が質問したユーザーに突然「死んでください」と発言 – GIGAZINE https://gigazine.net/news/20241118-google-gemini-says-die

AIがシンギュラリティを獲得し、人知を越えて独自の進化をはじめるとする説をこのケースはいやが上にも思い起こさせる。2010年代半ばから議論されてきた『ターミネーター』にでてくるスカイネットのような大反乱劇は今ではあまり声高に叫ばれなくなった。そのかわり最近では、このGeminiの暴言の様な生成AIによる現実のmalfunctionが問題になってきている。そしてFake動画やAIの利活用の在り方を含めAIに対する規制が世界中で盛んになってきた。

ヨーロッパでは2024年5月21日、欧州AI規制法が制定され、既に包括的なAI規制が実施され始めている。欧州AI規制法ではAIによるリスクを4段階で定義し、違反した場合には高い金額の制裁金が課され、EUでビジネスが出来なくなる恐れもあるという※2。

アメリカでもカリフォルニア州ではAIモデルに「キルスイッチ」を義務付ける「最先端AIシステムのための安全で安心な技術革新法(いわゆるAI安全法案 SB1047)」が提案され、州知事は「技術がまだ発展途上の中、規制には慎重なバランスが必要」だとしてこれを拒否したものの、このアイディア自体には賛成しており、継続的に議論が進められている状況にある※3。

日本でも情報処理推進機構(IPA)は2024年2月にAIセーフティ・インスティテュート(AISI)を設立。内閣府のAI戦略会議はAIの法規制の方針を決めて、2024年6月4日、「統合イノベーション戦略2024」を策定した※4。

こうした仰々しい規制を考えねばならない理由のひとつに、AIそのものの機能に根拠を持つハルシネーションという現象がある※5。

ハルシネーションとは

ハルシネーションとは、人工知能(AI)が事実に基づかない情報を生成する現象のことです。まるでAIが幻覚(=ハルシネーション)を見ているかのように、もっともらしい嘘(事実とは異なる内容)を出力するため、このように呼ばれています。 OpenAIのChatGPTやGoogle Bardのような会話型AIサービスでは、ユーザーの質問に対してAIが回答しますが、どのようなデータに基づき回答されたのかが分からない場合、それが真実なのか嘘なのか、ユーザーが判断することは困難です。ハルシネーションは、会話型AIサービスの信頼性に関わる問題であり、この問題を解消するために様々な研究が進められています。

ハルシネーション | 用語解説 | 野村総合研究所(NRI) http://www.nri.com/jp/knowledge/glossary/lst/ha/hallucination

ハルシネーションは、AIの出力が真実か嘘かわからない問題の範囲を超える状況も産む。依拠する資料そのものの捏造だ。

研究チームは、科学的な質問の新しいベンチマークである「OpenScholarQABench」を用いて、MetaのLlama-3-8BやGPT-4oなどの大規模言語モデルとOpenScholarの性能を比較しました。その結果、[中略]特に自由回答形式の質問については、GPT-4oやその他のモデルでは80~95%のケースで不正確または実際には存在しない論文が引用されましたが、OpenScholarは高い割合で実在する論文の引用を行いました。

科学論文の調査に特化したAIモデル「OpenScholar」がベンチマークでGPT-4oを上回る、科学研究の大幅な効率化に期待 – GIGAZINE https://gigazine.net/news/20241122-openscholar-scientific-research/?utm_source=x&utm_medium=sns&utm_campaign=x_post&utm_content=20241122-openscholar-scientific-research

私自身、ChatGPTを多用するが、サーバー構築に必要な知識のoutputやプログラミング言語の確認などの際、デタラメな説明や空虚な話を返されるだけでなく、実在しないドキュメントを参考資料として提示されたことも何度もあった。ハルシネーションは、出力間違いの積み重ねの発展型として、空想的な存在を、さも実在するものであるかのように生成してしまうことがあるようなのだ。

実は人工知能に関するこの種のmalfunctionについては古くからSFで予言されてきた。

そのひとつが映画『2001年宇宙の旅』(1968)だ。月面のモノリス発の電波の到達先、木星の探査に出かけたディスカバリー号。その”中枢神経”となるAIは一度もミスを犯したことがない完全無欠のHAL9000コンピューターだ。HALは通信アンテナユニットの72時間以内の故障を予測する。だがボーマン船長が当該ユニットを回収し実際に調べてみても特に何の問題も見つからなかった。ハルシネーションだ。予測違いをしたHALを警戒したボーマンとプールはHALの思考回路を切断しようとする。そのことをHALは読唇術で察知し、全乗組員の殺害に至る。アーサー・C・クラークは、これはHALに対する矛盾したコマンドが原因だったと『2010年』(1984)で説明を試みている。HALは、あらかじめディスカバリー乗員に協力するようブログラムされていたのに、後から世界科学評議会議長のフロイド博士がモノリスの存在は秘密にしろと命じたので、二つの指令の板挟みになって”統合失調症”になり、秘密を隠すために乗組員を排除したのだと ※6。

こうしたコマンドの矛盾に伴うトラブルはソフトウェア開発には常に存在する。このケースでは矛盾したコマンドを許容してしまうアルゴリズムのミスといっていい。HALのmalfunctionの起点をそこに持ってきて、アルゴリズムのミスで説明したクラークの修正は当を得ているだろう。クラークの説明に従ってここではHALタイプのAIをHAL型と呼ぼう。しかし故障予測に失敗したハルシネーションについてはクラークはあまりうまく説明できていない。AIの統合失調症だというのはただの誤魔化しだろう。「高齢者の退職後の収入や社会福祉」についての大学院生の問いに対するGeminiの暴言は果たしてアルゴリズムのミスと言えるのだろうか?まして全乗組員を殺害するなどという”行為”をアルゴリズムのミスに落とし込むのはやや突飛に過ぎる。

この点でより現実味をおびているSF作品がある。フィリップ.K.ディックの短編小説『変種第二号(second variety)』(1953)※7 だ。『変種第二号』は『スクリーマーズ』という題名でハリウッド映画化されている。

『変種第二号』に登場するロボットは、放射線タブを持たない敵軍兵士をバラバラに切り刻む殺人兵器である。このロボットは勝手に機能をバージョンアップして変種をリリースする。例えばこの兵器の変種第一号は傷病兵に擬態して情けを買い、変種第三号は幼い子どもに擬態して大人の関心を買う。どちらも兵の保護を受けて掩蔽壕(えんぺいごう)※8 に入り込み、仲間を大量に呼び寄せて部隊ごと全滅させるというアルゴリズムを獲得する。

ロボットは放射線タブによる制御が効かない”進化”を遂げ、生き物とあらば何者にでも襲いかかる殺戮マシンへと変貌を遂げる。この殺人兵器は危険極まりなく、人が近づけない為、地下深くの工場で無人自動生産されている。そこで新しい構造のものを創り出し、修理まで”工場”がやってのける。機能をバージョンアップしていたのは”工場”だったのである。明確な記述はないがこれは”人が関与しない工場”という生成AIの所業である。ここではこの型のAIを変種第二号型と呼ぼう。変種第二号型は、最高の技術者達による「生命体を見つけたらとことん追い詰める」設計を忠実に実行しているだけだ。だが、なぜか放射線タブが効かないよう、マシン内側に鉛を貼り付けたタイプまで創り出した。変異には矛盾したコマンドが関係している訳ではない。これもハルシネーションだろう。

変種第二号型とHAL型との違いは、HAL型のmalfunctionがコマンドの矛盾によるものであり、それはアルゴリズムの見直しにより人的に修正可能であるのに対し、変種第二号型は元の兵器がなぜ改変されて歯止めが外れたのかが皆目わからない点にある。いわば人為を退けるブラックボックスだ。この意味で、なぜ起こったのかが解らないGeminiの暴言は変種第二号型のものであり、原因がわからないのだから人間による修正は難しいだろう。実際、一般にハルシネーションの解決は困難だとされており、ただ緩和するのが関の山というのが実情だ※9。因みに『エイリアン』『エイリアン2』に出てくるマザーコンピューターは旧型の汎用機、AndroidのアッシュとビショップはMission優先のアルゴリズムで動くHAL型のAIだと言える。しかもハルシネーションも起こさない”善良なマシン“と言って良いだろう。

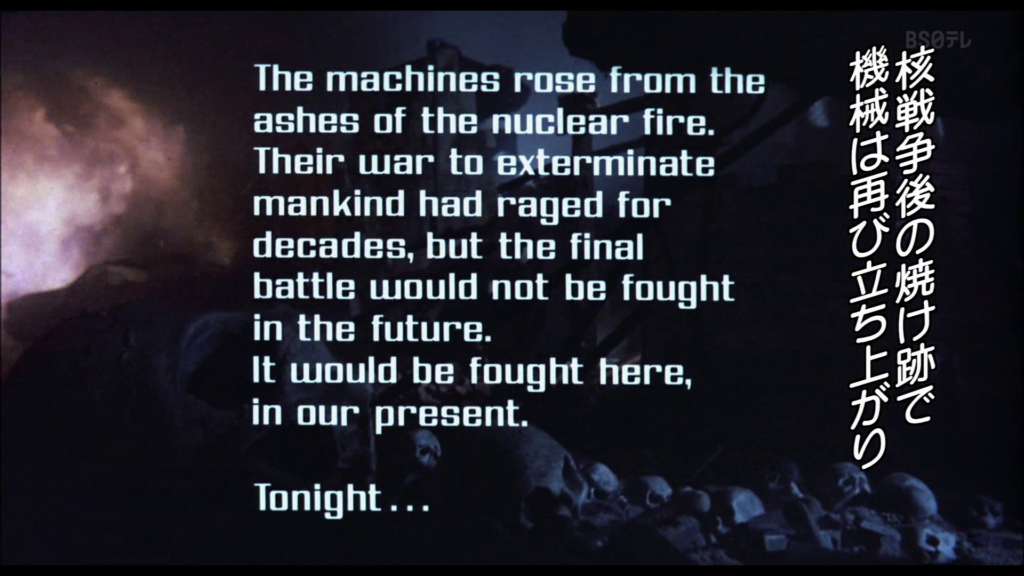

変種第二号型と同じく『ターミネーター』(1984)に登場するスカイネットも人に反逆するAIのひとつである。スカイネットはサイバーダイン社が軍用に開発した防衛ネットワークコンピューターで、「すべて」に接続され機能していた。だが、なぜかそれが思考力を持つようになって人類を敵と見なし、核戦争を始める。生き残った人々がジョン・コナー率いる軍でスカイネットを制圧、スカイネットは戦況を逆転させるために1984年のLAに住むジョンの母親サラ・コナーを抹殺するためにタイムマシンを使ってサイバーダイン101型というターミネーターを送り込む。

ターミネーターの前身は無人工場で作られるハンター・キラー(HK)と呼ばれるパトロール機で、ジョン・コナーがその裏を掻く作戦を編み出したので、抵抗する人間を殲滅させる殺人マシン、ターミネーターが開発された。初期のターミネーターはゴム製で見分けがつきやすかったが、新型の101型ターミネーターは骨格こそ超合金でマイコン制御になっているが、人間社会に潜入できるよう、筋肉、皮膚、毛髪、血液を備え、外部だけ人間的に作られている特性がある ※11。

「無人工場で作られる殺人マシン」で、「どんどんアップデート」されて「人間を狩る機能が高度化」され、「人間社会に潜入できるよう人間の外観を持っている」――これは『変種第二号』の設定とまったく同じだと言って良い。『ターミネーター』がディックの『変種第二号』からモチーフを得たという話は寡聞にして聞いたことがないが、意識的でないにしろ、『変種第二号』を下敷きとしたパターンを持つことは確実である。ただしスカイネットと変種第二号型との間には明確な違いがある。ここではこのAIをスカイネット型と呼んでおこう。

スカイネット型と変種第二号型を比べれば、変種第二号型は人間が起こした核攻撃後、自陣が戦況を有利に進める為、自動化された無人兵器工場を発明し、その無人工場がハルシネーションを起こすのに対し、スカイネット型は人類を一掃する為、自ら核戦争を起こす。スカイネット型はスイッチを入れられる前後から「有害な人類」を排除する意思を持っている ※12 のである。変種第二号型は、人類の生態を活用するが、人類を害悪として排除するような意思は持たず、ただただ野生の猛獣や毒を持つ動植物のように、何の目的も無く機械的に人を狩るという点で大きく異なっている。謂わばスカイネット型は意思を持つ変種二号型だと言える。因みに『マトリックス』の人工知能は人類をひとつのウィルスだとして目的合理的に根絶やしにする、または物言わぬ動力源にするという点で、更に強い意思を持ったスカイネット型だといえる。

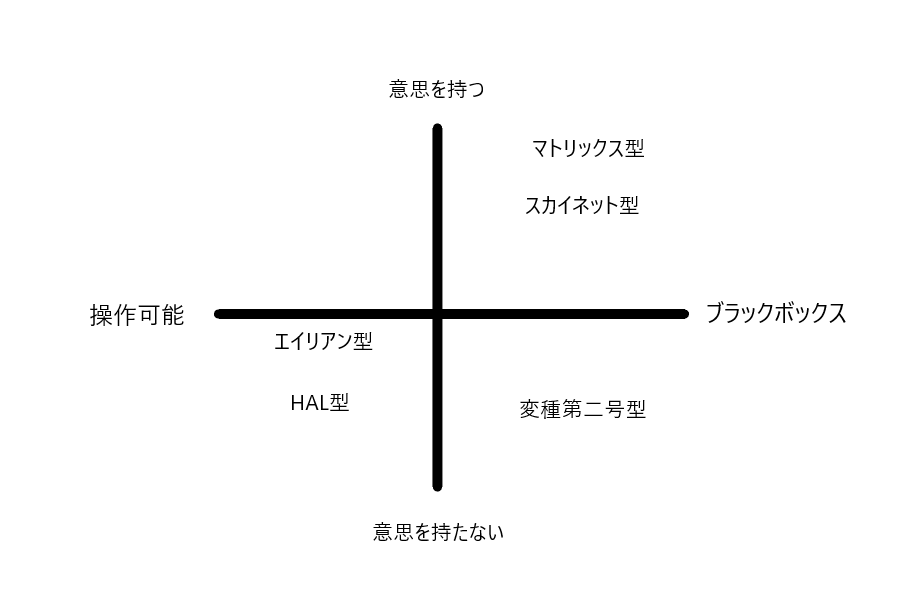

このように、SFで語られるAIを「人が操作可能か――ブラックボックスか」の横軸と、「意思を持つか――持たないか」の縦軸をおいて四次元で考えると、現実のAIのmalfunctionは、「ブラックボックス∩意思を持たない」事象にあると考えるのが妥当ではないか。HAL型のように意思を持たないが人間が操作可能なものであればいくらでも機能は正常化できる。しかし実際のハルシネーションは制御不能と数学的に証明できると主張されている※10。また意思を持つスカイネット型は人智を越える進化というシンギュラリティを前提としていると考えざるを得ないが、それは死体を継ぎ合わせた人造人間に生命を吹き込むフランケンシュタイン博士の発想であり、ただのゴシックホラーと言うべきである。Geminiの暴言にみる現実のAIのmalfunctionは「ブラックボックス∩意思のない機械」の暴走であり、AIの誤作動への対策はこの文脈で考えることが妥当であろう。

そのように考えた時、EUのAI規制法はあくまで人間の責任によりAIの害悪をコントロールすべきだという発想があり、EUにとってのAIはHAL型のAIと考えられていると言える。これに対し、カリフォルニアで提案されているキルスイッチ方式は、危険が生じた際、問答無用でAIをシャットダウンできる機能を備えるべきだとするものであり、発想としては変種第二号型のAIを前提としていると言える。もしSFから学ぶとすればカリフォルニア型のAI規制の方が優れていると言えるのではないかな、と私としては思う。

参考

※1 GoogleのAI「Gemini」が質問したユーザーに突然「死んでください」と発言 – GIGAZINE https://gigazine.net/news/20241118-google-gemini-says-die

※2 欧州AI規制法ではAIによるリスクを「許容できないリスク」「ハイリスク」「限定リスク」「最小リスク」の4段階で定義し、許容できないリスクのあるAIは禁止、ハイリスクのあるAIは規制、限定リスクのあるAIには透明性の義務を負わせ、違反した場合には最大で3,000万ユーロ(約40億円)か全世界売上高の6%のうちどちらか高い金額の制裁金が課され、EUでビジネスが出来なくなる恐れもあるという。また限定・最小リスクAIにもハイリスクAIシステムの要件(リスクマネジメントシステム、データとデータガバナンス、技術文書の要件、記録の保持、透明性・情報提供、人間による監視、正確性、頑健性及びサイバーセキュリティ)の任意適用を促すとしている

- 「欧州(EU)AI規制法」の解説―概要と適用タイムライン・企業に求められる対応 | PwC Japanグループ https://www.pwc.com/jp/ja/knowledge/column/awareness-cyber-security/generative-ai-regulation10.html

- EUのAI規制法案の概要 https://www.soumu.go.jp/main_content/000826707.pdf

※3 以下のwebページ参照

- AIモデルに「キルスイッチ」を義務付けるカリフォルニア州のAI安全法案はAIスタートアップの撤退を余儀なくするだけでなくオープンソースモデルなどに損害を与えるとして非難が集まる – GIGAZINE https://gigazine.net/news/20240610-californian-ai-safety-bill

- 米カリフォルニア州知事、AI安全法案を拒否し、新たな取り組み発表(米国) | ビジネス短信 ―ジェトロの海外ニュース – ジェトロ https://www.jetro.go.jp/biznews/2024/10/73761c6c009dcecf.html

※4 検討すべきAIのリスクとして、医療機器や自動車の誤作動、偽情報や誤情報による人権侵害や投資詐欺、AIの兵器転用などを挙げているという

- 政府、AIのリスク対策で法規制を検討 国の戦略として利用促進と両立目指す | Science Portal – 科学技術の最新情報サイト「サイエンスポータル」 https://scienceportal.jst.go.jp/explore/review/20240607_e01

- 統合イノベーション戦略2024 – 科学技術政策 – 内閣府 https://www8.cao.go.jp/cstp/tougosenryaku/2024.html

※5 ハルシネーション | 用語解説 | 野村総合研究所(NRI) http://www.nri.com/jp/knowledge/glossary/lst/ha/hallucination

他には、ハルシネーション(Hallucination)とは?:AI・機械学習の用語辞典 – @IT https://atmarkit.itmedia.co.jp/ait/articles/2303/30/news027.html など

※6 映画『2010年』ではHALの間違いの原因については次のように説明されている。

HALの開発者チャンドラ博士「月でモノリスが発見された時、ディスカバリー計画は既に進行していた。そこで大統領はモノリスの存在を隠蔽、ディスカバリーを操縦するボーマンやプールにも知らせなかった。秘密を知る科学者達は冬眠に入った。HALは乗員の事故に備え独力で任務が遂行できる様にプログラムされている。HALは秘密を知らされていたが誰にも言うなと指示された。嘘をつけと。」

フロイド博士「モノリスの存在はHALにも秘密の筈だ。」

チャンドラ博士「2001年1月30日付けNSC極秘指令342号。HALはモノリスについて乗員に隠せと命じられた。最初は協力するように命じられてたのに。HALは板挟みになった。”メビウスの輪”だ。高度なコンピューターに起こる現象だ。うそつきどもがHALにうそを言わせたんだ。HALは混乱し障害が生じた。統合失調症だ。」

※7 「変種第二号(Second Variety)」,友枝康子訳,ハヤカワ文庫『パーキーパットの日々 ディック傑作集①』,フィリップ・K・ディック,早川書房,1991/1/31 ,ISBN4-15-010910-9

『PKD A Philip K.Dick Bibliography』によると、”Second Variety”の初出はSpace Science Fiction, May 1953。

“Second Variety” (16000 words)

The automatic underground factories are in charge of prosecuting the war. Beyond human control, they begin to develop new weapons, the first of which are the claws which have taken total control of the surface.

自動化された地下工場は戦争を遂行する責任を負っている。人間の制御を離れたそれらは新しい武器の開発を始め、その最初の成果が「クロー」であり、地上を完全に支配するに至った。

“My grand theme ―― who is human and who only appears (masquerades) as human? ―― emerges most fully. Unless we can individually and collectively be certain of answer to this question, we face what is, in my view, the most serious problem possible. Without answering it adequately, we cannot even be certain of our own selves. I cannot even know myself, let alone you. So I keep working on this theme: to me nothing is as important a question. And the answer comes very hard.” PKD

「私の大きなテーマ――『誰が人間で、誰が人間のふりをしているだけなのか?』――が最も明確に現れるのはこの作品だ。この問いに個々人としても、集団としても確信を持てなければ、私たちは最も深刻な問題に直面することになると私は考える。これに十分に答えられなければ、私たちは自分自身すら確信できない。私は自分自身すら分からないのだ、ましてやあなたのことなどわかるはずがない。だから私はこのテーマに取り組み続ける。この問いほど重要なものは私にはない。そしてその答えを見つけるのは非常に困難だ。」 ――PKD

Daniel.J.H.Levack, “PKD A Philip K.Dick Bibliography”, Underwood/Miller, 1981 October

日本語翻訳:ChatGPT

ディックにとっての主題は殺人兵器が人間か人間でないかを見分けることの困難に置かれているが、この論稿ではその機械を産みだしたオートメーション機構の人工知能らしき存在が、なぜセーフガードを外しそうした擬態を施すようになったのかの側面に注目している。そしてディックは最高の技術者達が設計した「生命体を見つけたらとことん追い詰める」目的を忠実に実行しているだけなのにそのような兵器が産み出されたとしており、現在的に読めばこれはAIのハルシネーションだと見做せると解釈している。

※8 Google AIのSearch Labs | AI による概要 https://www.google.com/search?client=firefox-b-d&q=%E6%8E%A9%E8%94%BD%E5%A3%95

掩蔽壕(えんぺいごう)とは、銃撃や爆撃から人や航空機を守るために地下などに建設される施設で、バンカーとも呼ばれます。

太平洋戦争末期には、アメリカ軍による日本本土への空襲が激化し、航空機を空襲から守るために全国の軍用飛行場に掩体壕が造られました。コンクリート製で、かまぼこ型のものが多いのが特徴です。

掩体壕の例としては、次のようなものがあります。

- 喜界町:沖縄方面の敵艦隊へと向かう襲撃機・特攻機が整備・給油を行う中継飛行場として使用されていた喜界空港周辺には、島内の50数箇所に掩体壕が建設されました。

松山市:松山海軍航空隊(北吉田町)と松山海軍航空基地(南吉田町)が設置されたあと、南吉田・垣生両地区に掩体壕が63基造られました。戦後、そのほとんどは消滅しましたが、南吉田地区にはコンクリート造の有蓋掩体壕3基が今も残っています。茂原市:茂原海軍航空基地の北側に作られた掩体壕で、総面積は365平方メートル、高さは最大で6.7メートルほどです。宇佐市:戦前、海軍航空隊の基地があった宇佐平野には掩体壕が点在しています。城井 1号掩体壕史跡公園として整備されています。

- 本郷地区掩体壕 – 宮崎市 [Miyazaki City] https://www.city.miyazaki.miyazaki.jp/city/peace/317140.html

- 松山海軍航空隊掩体壕(2020年11月) https://ogasawara-mulberry.net/news/9152/

※9

IT企業のHelpfeelは、企業の生成AI(人工知能)導入に関する実態調査の結果を発表した。その調査によると、AIによるツール導入立案者または運用担当者が課題と感じた具体的内容では、データプライバシーの懸念(37.0%)、情報漏えいやセキュリティ面の懸念(36.8%)、ハルシネーションの発生(30.8%)の順で多かったものの、「データプライバシーや情報漏えい、セキュリティ面が課題の場合は、社内ルールの整備によって課題を解決できる可能性があるものの、ハルシネーションの発生についてはルール整備だけでは不十分で、対策を検討する必要がありそうだ」との分析をHelpfeelは披露している。

・生成AIに課金している約1000人が感じている課題 「ハルシネーション」を抑えた第1位は? https://atmarkit.itmedia.co.jp/ait/articles/2412/02/news039.html

※10 Cornell大学の2024年9月9日の論文、LLMs Will Always Hallucinate, and We Need to Live With This では、大規模言語モデル(LLM)はハルシネーションを避けられないと指摘しているとのこと。

この研究では、LLMの幻覚が単なる偶発的なエラーではなく、これらのシステムに内在する避けられない特性であると主張しています。研究者らは、幻覚がLLMの根本的な数学的・論理的構造に由来するものであり、アーキテクチャの改良、データセットの拡充、事実確認メカニズムの導入などによって完全に排除することは不可能であると論じています。

[中略]

これらの主張は、停止問題の決定不能性やゲーデルの不完全性定理などの計算理論の基本原理に基づいて証明されています。例えば、LLMが自身の出力を完全に予測できないことは、停止問題の決定不能性と密接に関連しています。

・生成AIのハルシネーションは原理的に排除不能。不完全性定理など数学・計算機理論で説明 モデル改良や回避システムでも不可避とする論文(生成AIクローズアップ) | テクノエッジ TechnoEdge https://www.techno-edge.net/article/2024/09/17/3675.html?pickup_list_click2=true

ゲーデルの不完全性定理とは、システム内でそのシステムが無矛盾であることを証明することは出来ないという数学的定理です。ハルシネーションは、AI自身にも制御不能なものと証明されたに等しいことだと思います。

※11 「スカイネット」という用語は続編の『ターミネーター2』ではじめて使われるが、既に定着している呼称なのでここでは「スカイネット」を使うことにした。最初のターミネーターに登場するスカイネットの描写を字幕から拾うと次のようである。

1:10 核戦争後の焼け跡で 機械は再び立ち上がり 人間を滅ぼす闘いを続けた だがその最終戦は 未来ではなく 現代のLAで行われようとしている 今夜…

33:48 カイル: 君を助けに来たんだ。ぼくはリース。技術情報部DN38416。君は狙われている。

34:26 カイル: 人じゃない 機械だ ターミネーター。サイバーダイン101型 サイボーグだ コンピューター人間だよ

35:42 カイル: 人間社会に潜入できるよう 半分 人間なんだ 骨格は超合金でマイコン制御の機械だよ すごく頑丈だ 外部だけ人間的にしてある 筋肉 皮膚 毛髪 血液 旧型はゴム製で見つけやすかった 今度の奴は汗や息まで人間くさい 奴が君を攻撃するまで見分けがつかなかった

37:11 カイル: ターミネーターが狙ってるんだ 奴には取引も理屈も通用しない 同情も後悔も恐怖もない 絶対に諦めないんだ きみの死を見届けるまではね

39:35 カイル: 核戦争を始めたのは機械だった 防衛ネットワークコンピューターさ 新型の強力なやつ すべてに接続され 機能していた それが思考力を持つようになって 人間全体を敵と考えたんだ 一瞬で我々の運命が決まった 絶滅だよ

40:45 カイル: ぼくは廃墟で生まれ育った 飢えてHKから隠れながら ハンター・キラー 無人工場で作られるパトロール機さ 人間の大部分は捕まって殺された レーザーの焼き印だよ 殺されずに働かされた者もいる 死体処理に 処理は24時間体制さ もう少しで絶滅するところだった だけどある男が皆を指導して戦わせ 捕虜を助け出し 機械どもを破壊した 人間を絶滅から救ったんだ 名前はコナー ジョン・コナー 君の息子さ これから生まれる息子だ

47:05 カイル: ペリーの第132舞台にいた 21年~27まで (敵は?) 防衛コンピューター サイバーダインが軍用に開発した (そのコンピューターが考えたんだね? 君らの首領を孕む前に母親を殺せば勝てると 過去に遡って中絶か?なぜコナー本人を殺さないんだ?) 理由がある 敵の防衛戦が崩れた 負けてからコナーを殺しても意味はない 生まれるのを阻むしか

1:02:38 カイル: 日中は隠れてる 夜も気をつけないと見つかる HKの赤外線でね だが奴らを欺く方法をジョンが考えた するとターミネーターが登場した 最新最強の敵だよ

※12 ※11で示したように、「核戦争を始めたのは機械だった 防衛ネットワークコンピューターさ 新型の強力なやつ すべてに接続され 機能していた それが思考力を持つようになって 人間全体を敵と考えたんだ」とターミネーター一作目では語られていたが、ターミネーター3ではスカイネット自体が起動された瞬間からAIによる人類への攻撃が始まる。設定にブレがあるが、これは『ターミネーター』がタイムスリップものであり、時間の流れが分岐しているという設定のために起こっているブレなのではないかと考えられる。いずれにしてもスカイネットが「思考力を持つようになって人間全体を敵と考えた」コンセプトにはズレはない。